Le fichier robots.txt est un fichier texte placé à la racine d’un site web (par exemple, https://trafic-seo.com/robots.txt). Le robots.txt est utilisé pour donner des instructions aux robots d’exploration des moteurs de recherche (aussi appelés crawlers ou spiders) sur les pages ou sections du site web qu’ils peuvent ou ne doivent pas explorer.

Le fichier robots.txt est un outil essentiel pour votre optimisation SEO technique. Ce fichier contribue ainsi à une meilleure gestion de votre budget crawl et de l’indexation de vos pages web.

L’importance du robots.txt pour votre SEO ?

Le fichier robots.txt joue un rôle important dans votre stratégie SEO. Sur de gros sites, ou des sites assez dynamiques avec des mises à jour fréquentes, ce fichier régule l’exploration de votre site et oblige les moteurs de recherche à se focaliser sur les pages les plus importantes.

En limitant l’exploration des pages non pertinentes ou sensibles (comme les pages de connexion, les sections administratives, etc.), les robots se concentrent sur les pages les plus importantes pour le référencement, améliorant ainsi l’efficacité de l’exploration.

Le budget crawl est donc utilisé de manière optimale. Vous favorisez ainsi l’indexation des pages essentielles pour le SEO.

Comprendre la syntaxe d’un robots.txt

- User-agent: spécifie à quel robot s’applique la directive (par exemple, User-agent: * s’applique à tous les robots).

User-agent: Googlebot

Disallow:

User-agent: *

Disallow: /

Dans cet exemple, Googlebot est autorisé à explorer le site. En revanche, tous les autres crawlers ne sont pas autorisés à explorer le site.

- Disallow: indique les chemins que le robot ne doit pas explorer.

Par exemple, Disallow: /admin interdit l’accès au répertoire /admin.

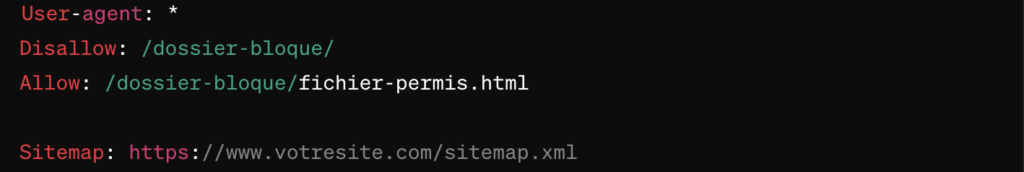

- Allow: permet d’autoriser spécifiquement l’accès à certains chemins, même s’ils sont interdits par une directive plus générale de “Disallow”.

Robots.txt : exemples de configuration

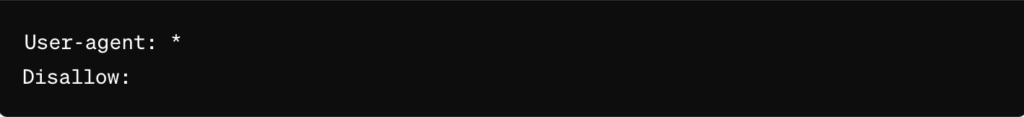

Cette instruction autorise tous les robots à explorer le site.

Cette ligne interdit l’accès à un dossier spécifique du site.

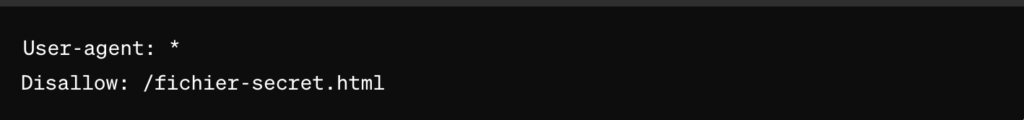

l’instruction bloque un fichier spécifique.

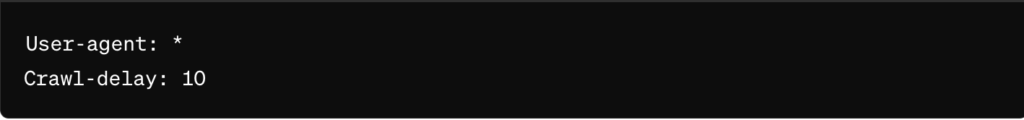

Certains robots supportent la directive Crawl-delay pour spécifier un délai entre les requêtes afin de ne pas surcharger le serveur.

Crawl-delay indique au robot la fréquence à laquelle il doit explorer le site.

Il est également recommandé d’insérer le lien du sitemap.xml dans le fichier robots.txt.

Configurer le robots.txt sur WordPress

Pour configurer le robots.txt sur votre site WordPress, vous pouvez passer par des extensions. Des plugins disponibles gratuitement permettent de gérer efficacement cette tâche. Voici quelques exemples :

Yoast SEO

- Yoast est l’un des plugins les plus populaires pour le SEO sur WordPress. Il permet de configurer et de modifier facilement le fichier robots.txt directement depuis le tableau de bord WordPress.

Une fois installé, allez dans “SEO” > “Outils” > “Éditeur de fichiers” pour accéder et éditer le fichier robots.txt.

All in One SEO Pack

- Un autre plugin SEO largement utilisé qui offre également la possibilité de gérer le fichier robots.txt.

Après l’installation, allez dans “All in One SEO” > “Outils” pour trouver l’option d’édition du fichier robots.txt.

Rank Math SEO

- Rank Math est un plugin SEO puissant et convivial qui inclut des options pour gérer le fichier robots.txt.

Vous pouvez accéder à cette fonctionnalité en allant dans “Rank Math” > “SEO Général” > “Éditeur de Fichiers”.

Wp robots.txt

- Ce plugin est spécialement conçu pour la gestion du fichier robots.txt. Il offre une interface simple pour créer et modifier le fichier robots.txt sans avoir besoin de toucher au code.

Une fois activé, le plugin ajoute un menu “Robots.txt” sous le menu “Paramètres” dans le tableau de bord WordPress.

Comment tester le robots.txt ?

Il est important de tester le fichier robots.txt pour voir si les instructions sont bien compréhensibles.

Commencez par accéder directement à votre fichier robots.txt en entrant l’URL dans votre navigateur pour vous assurer qu’elle soit bien accessible. https://tonsite.robots.txt

Vous pouvez aussi utiliser des outils en ligne pour valider et tester votre fichier robots.txt :

- Google Search Console : Cet outil de Google permet de tester votre fichier robots.txt. Vous pouvez trouver cette fonctionnalité dans la section “Outils et rapports obsolètes” sous “Tester robots.txt”.

- Allez sur Google Search Console

- Connectez-vous et sélectionnez votre propriété.

- Naviguez jusqu’à “Outils et rapports obsolètes” et choisissez “Tester robots.txt”.

- Entrez l’URL d’une page pour vérifier si elle est bloquée par les directives de votre robots.txt.

Il existe plusieurs outils tiers qui peuvent vous aider à vérifier et tester votre fichier robots.txt :

- Robots.txt Checker : Ce service gratuit analyse votre fichier robots.txt et vérifie les erreurs potentielles.

- Visitez Robots.txt Checker

- SEOBook’s Robots.txt Analyzer : Cet outil permet de coller le contenu de votre fichier robots.txt et de tester les URLs pour vérifier si elles sont bloquées ou autorisées.

- Visitez SEOBook Robots.txt Analyzer